| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- jquery

- huggingface

- polygon

- Remix

- 배포

- 블록체인

- React

- nginx

- nft

- netfunnel

- PM2

- NextJS

- 티스토리챌린지

- chatGPT

- Kaikas

- miniconda

- 오블완

- metamask

- node

- Ai

- WSL

- threejs

- AWS

- Python

- exceljs

- 라라벨

- Laravel

- CSS

- 회고

- docker

- Today

- Total

박주니 개발 정리

Deepseek R1 오픈소스 후기 본문

시작전 준비)

1. Hugging Face Token 준비

Hugging Face Token값 가져오기

1. Hugging Face을 로그인하고 Access Tokens를 클릭합니다. https://huggingface.co/ Hugging Face – The AI community building the future.The Home of Machine Learning Create, discover and collaborate on ML better. We provide paid Compute and Ent

junhee6773.tistory.com

Hugging Face Deepseek R1 권한 허용은 별도 하지 않습니다.

https://huggingface.co/deepseek-ai/DeepSeek-R1

deepseek-ai/DeepSeek-R1 · Hugging Face

DeepSeek-R1 Paper Link👁️ 1. Introduction We introduce our first-generation reasoning models, DeepSeek-R1-Zero and DeepSeek-R1. DeepSeek-R1-Zero, a model trained via large-scale reinforcement learning (RL) without supervised fine-tuning (SFT) as a prel

huggingface.co

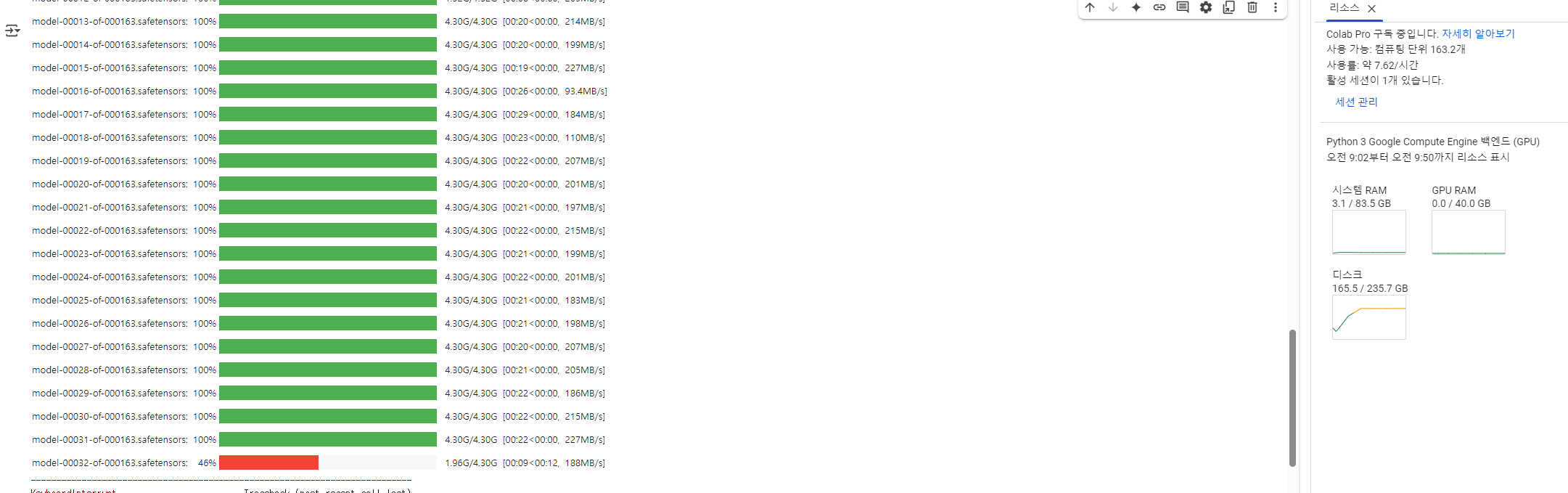

저는 Colab에서 https://colab.research.google.com/ Pro 구독을 하고

Google Colab

colab.research.google.com

런타임 유형을 A100으로 설정하고 진행했습니다.

이제 Deepseek R1을 다운로드 진행하는 Python 코드입니다.

from transformers import AutoModelForCausalLM, AutoTokenizer, AutoConfig, BitsAndBytesConfig

import torch

import os

import subprocess

# 🔹 1️⃣ GCS 경로 설정 (최상위 루트처럼 사용)

GCS_BUCKET = "{{GCS 버킷명}}"✅ 본인의 GCS 버킷명으로 변경

GCS_MODEL_PATH = f"gs://{GCS_BUCKET}/deepseek-r1"

# 🔹 2️⃣ 모델 이름 설정

model_name = "deepseek-ai/DeepSeek-R1"

# 🔹 3️⃣ 임시 저장 경로 설정 (Colab 디스크 사용 최소화)

TEMP_MODEL_PATH = "/dev/shm/deepseek-r1" # ✅ Colab 디스크 대신 공유 메모리에 저장

# 🔹 4-bit 양자화 설정 (GPU에서 사용)

bnb_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_use_double_quant=True,

bnb_4bit_quant_type="nf4",

bnb_4bit_compute_dtype=torch.float16

)

# 🔹 4️⃣ GPU 사용 가능 여부 확인

device = "cuda" if torch.cuda.is_available() else "cpu"

print(f"✅ 실행 기기: {device}")

# 🔹 5️⃣ Hugging Face 모델 다운로드 (Colab RAM 디스크에 저장)

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

config = AutoConfig.from_pretrained(model_name, trust_remote_code=True)

# 🔹 FP8 Quantization 설정 제거

if hasattr(config, 'quantization_config'):

del config.quantization_config # ✅ FP8 설정 제거

# 🔹 6️⃣ 모델 로드

model = AutoModelForCausalLM.from_pretrained(

model_name,

config=config,

trust_remote_code=True

)

# 🔹 7️⃣ Colab의 `/dev/shm`에 임시 저장

os.makedirs(TEMP_MODEL_PATH, exist_ok=True)

tokenizer.save_pretrained(TEMP_MODEL_PATH)

model.save_pretrained(TEMP_MODEL_PATH)

print(f"✅ 모델이 임시 경로에 저장됨: {TEMP_MODEL_PATH}")

# 🔹 8️⃣ GCS에 업로드 (`gsutil cp -r`)

subprocess.run(["gsutil", "-m", "cp", "-r", TEMP_MODEL_PATH, GCS_MODEL_PATH])

print(f"✅ 모델이 GCS에 직접 저장됨! ({GCS_MODEL_PATH})")

추가설명)

1. 경로를 GCS 설정으로 진행한 이유?

이미지와 같이 일반적으로 딥시크 R1 다운로드를 할 때 20%정도밖에 안됬는데 100GB를 사용이상 소모가 되었고 현재 컴퓨터로는 여유 디스크가 없어서 GCS바로 접근할 수 있는 방법을 구상해봤습니다.

2. GCS로 바로 딥시크 R1 다운로도가 안되는 이유?

Hugging Face에서 다운로드를 진행할 경우 무조건 로컬에 전체 다운로드 받고 그 모델을 GCS에 업데이트해야합니다.

후기)

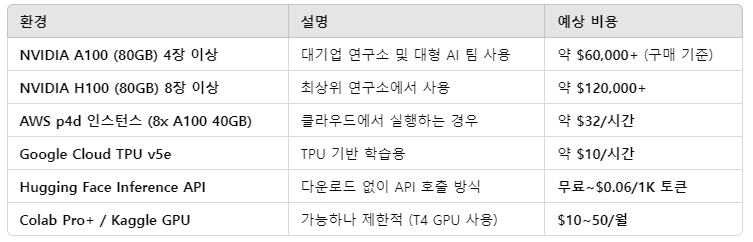

딥시크 R1 최적 사양을 확인해보니

DeepSeek R1의 주요 스펙

- 모델 크기: DeepSeek R1 67B는 약 1TB+

- 모델 다운로드 시 RAM 사용량: 최소 512GB RAM 이상 필요

- 디스크 공간: SSD 기준 1.2TB 이상 필요 (Hugging Face 캐시 포함)

- VRAM 요구사항: A100 80GB 또는 H100급 GPU 4장 이상 필요

그 내용을 뒷받침할 영상은

https://www.youtube.com/watch?v=sxye9Ul7ppI

https://www.youtube.com/watch?v=k3LL5rW41B4

영상을 보면 모델을 다운로드 받아도 추후에 사용을 한다해도 지금 openai api처럼 성능을 올릴려면

성능에 맞게 GPU가 있어야합니다. 사실상 openai model 수준으로 올릴 때 사용되는 GPU보다는 저렴한거지 R1을 무료로 사용할 수 있는 것은 아니라는 것을 알았습니다. 무료로 사용할려면 그만한 스펙을 가진 서버를 가지고 있어야하는데 그것자체가 이미 무료가 아님을 증명하기 때문입니다.

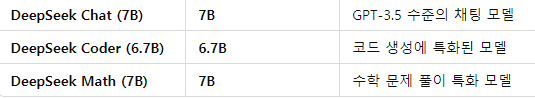

지금 사람들이 흔히 생각하는 딥시크를 무료로 다운로드 받고 사용하는 모델 수준은

이정도가 다운로드 받아서 간단하게 테스트해서 사용할 수 있지만 GPT-3.5 수준이기 때문에 정상적인 서비스를 할 때

퀄리티가 떨어질 수밖에 없습니다.

딥시크 플랫폼: https://api-docs.deepseek.com/

Your First API Call | DeepSeek API Docs

The DeepSeek API uses an API format compatible with OpenAI. By modifying the configuration, you can use the OpenAI SDK or softwares compatible with the OpenAI API to access the DeepSeek API.

api-docs.deepseek.com

딥시크 플랫폼은 딥시크 api를 이용하는데 사용 가격은 openai api 보다 저렴합니다.

하지만 모델을 다운로드 해서 사용하는거랑 플랫폼에서 api를 사용하는 거하고는 개발을 모르는 입장에서 보안적인 이슈가 취약하다고 볼 수밖에 없기 때문에 딥시크 api를 추천하는 것도 좋은 방법은 아니였습니다.

딥시크와 같은 성능 좋은 AI 모델이 가볍고 GPU 부담이 적을 때 다시 진행 후 공유하겠습니다.